整体跟踪分析导论¶

创建日期:2024 年 1 月 2 日 | 最后更新:2024 年 1 月 5 日 | 最后验证:2024 年 11 月 5 日

作者: Anupam Bhatnagar

在本教程中,我们将演示如何使用整体跟踪分析 (HTA) 来分析分布式训练作业的跟踪。请按照以下步骤开始。

安装 HTA¶

我们推荐使用 Conda 环境安装 HTA。要安装 Anaconda,请参阅Anaconda 官方文档。

使用 pip 安装 HTA

pip install HolisticTraceAnalysis

(可选且推荐) 设置 Conda 环境

# create the environment env_name conda create -n env_name # activate the environment conda activate env_name # When you are done, deactivate the environment by running ``conda deactivate``

开始¶

启动 Jupyter notebook 并将 trace_dir 变量设置为跟踪文件所在的路径。

from hta.trace_analysis import TraceAnalysis

trace_dir = "/path/to/folder/with/traces"

analyzer = TraceAnalysis(trace_dir=trace_dir)

时间分解¶

为了有效利用 GPU,了解它们在特定作业上花费时间的方式至关重要。它们主要用于计算、通信、内存事件,还是处于空闲状态?时间分解功能详细分析了在这三个类别中花费的时间。

空闲时间 - GPU 处于空闲状态。

计算时间 - GPU 用于矩阵乘法或向量运算。

非计算时间 - GPU 用于通信或内存事件。

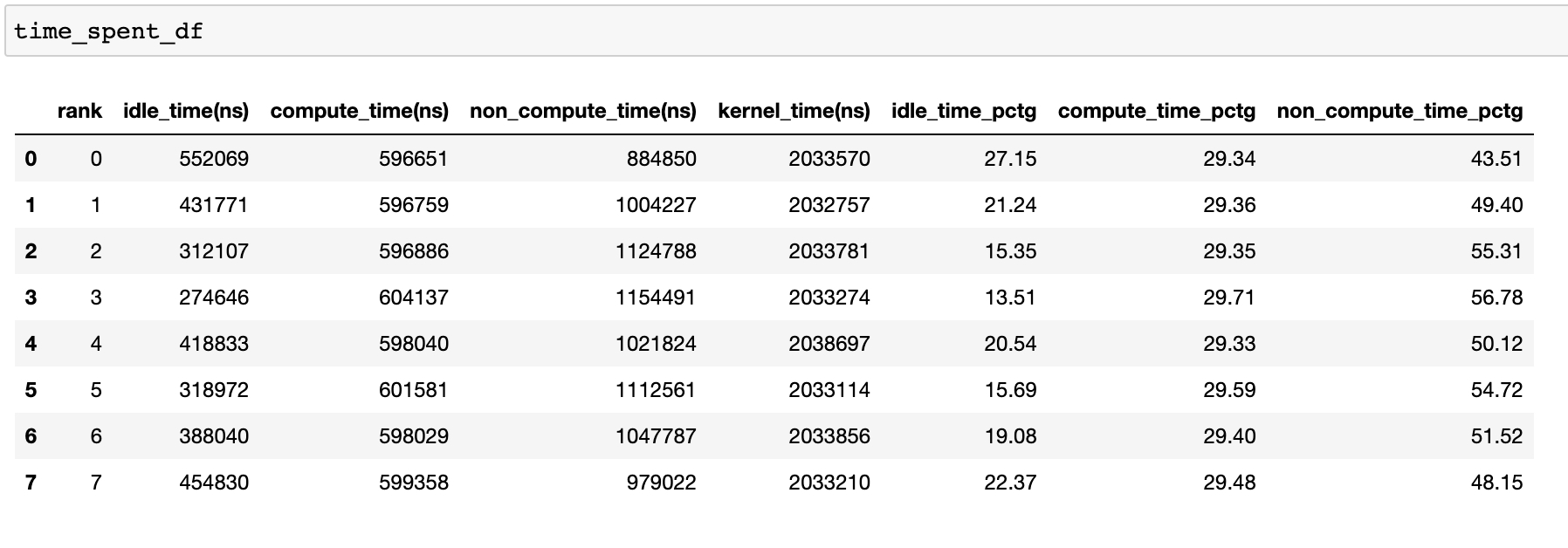

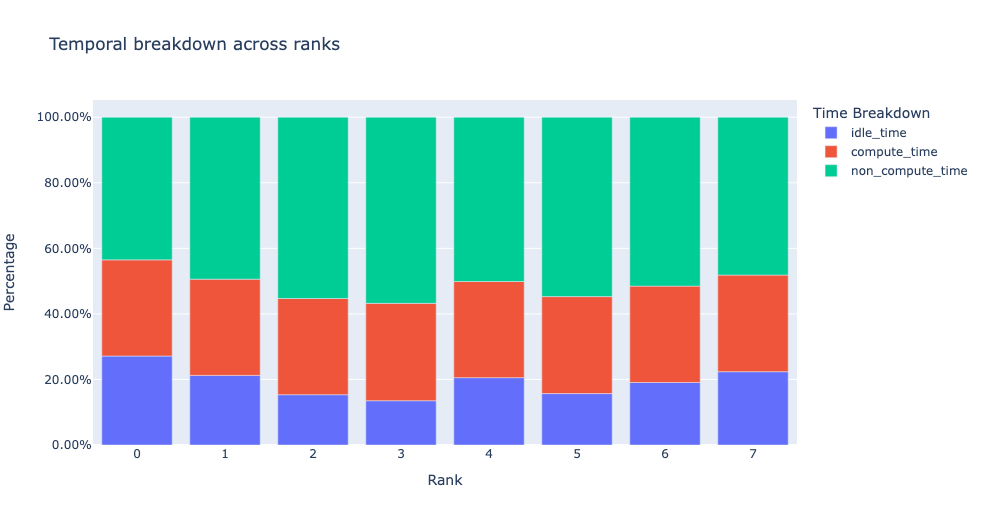

为了实现高训练效率,代码应最大化计算时间,最小化空闲时间和非计算时间。以下函数生成一个 dataframe,详细列出了每个 rank 的时间使用分解。

analyzer = TraceAnalysis(trace_dir = "/path/to/trace/folder")

time_spent_df = analyzer.get_temporal_breakdown()

当 get_temporal_breakdown 函数中的 visualize 参数设置为 True 时,它还会生成一个按 rank 分解的条形图。

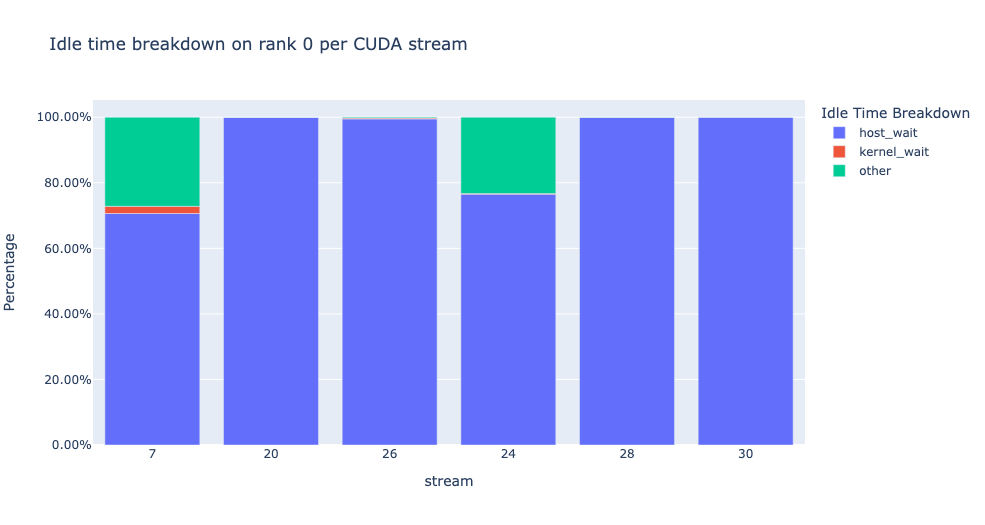

空闲时间分解¶

了解 GPU 空闲的时间量及其原因有助于指导优化策略。当 GPU 上没有运行内核时,它被认为是空闲的。我们开发了一种算法,将空闲时间分为三个不同的类别

Host 等待: 指的是 GPU 上的空闲时间,这是由于 CPU 入队内核不够快,无法使 GPU 得到充分利用。可以通过检查导致速度变慢的 CPU 操作符、增加批处理大小和应用操作符融合来解决这些低效问题。

Kernel 等待: 这指的是在 GPU 上启动连续内核时相关的短暂开销。可以通过使用 CUDA Graph 优化来最小化归因于此类别的空闲时间。

其他等待: 此类别包括当前无法归因的空闲时间,原因可能是信息不足。可能的原因包括使用 CUDA 事件在 CUDA 流之间同步以及启动内核时的延迟。

Host 等待时间可以解释为 GPU 由于 CPU 停顿的时间。要将空闲时间归因于 Kernel 等待,我们使用以下启发式方法

连续内核之间的间隔 < 阈值

默认阈值值为 30 纳秒,可以使用 consecutive_kernel_delay 参数进行配置。默认情况下,空闲时间分解仅计算 rank 0。为了计算其他 rank 的分解,请使用 get_idle_time_breakdown 函数中的 ranks 参数。空闲时间分解可以按如下方式生成

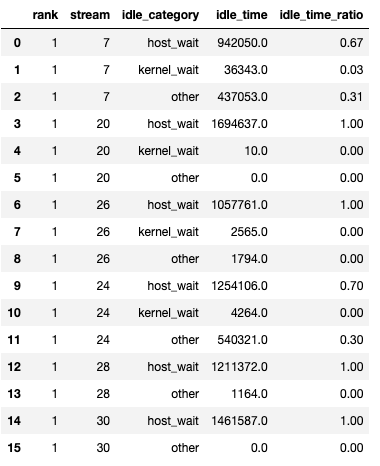

analyzer = TraceAnalysis(trace_dir = "/path/to/trace/folder")

idle_time_df = analyzer.get_idle_time_breakdown()

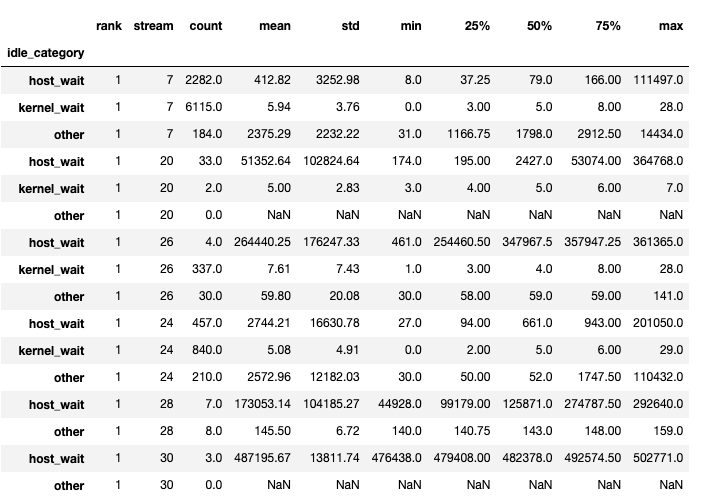

该函数返回一个 dataframe 元组。第一个 dataframe 包含每个 rank 在每个流上按类别划分的空闲时间。

第二个 dataframe 在 show_idle_interval_stats 设置为 True 时生成。它包含每个 rank 在每个流上的空闲时间摘要统计信息。

提示

默认情况下,空闲时间分解显示每个空闲时间类别的百分比。将 visualize_pctg 参数设置为 False,函数将以绝对时间作为 Y 轴进行渲染。

Kernel 分解¶

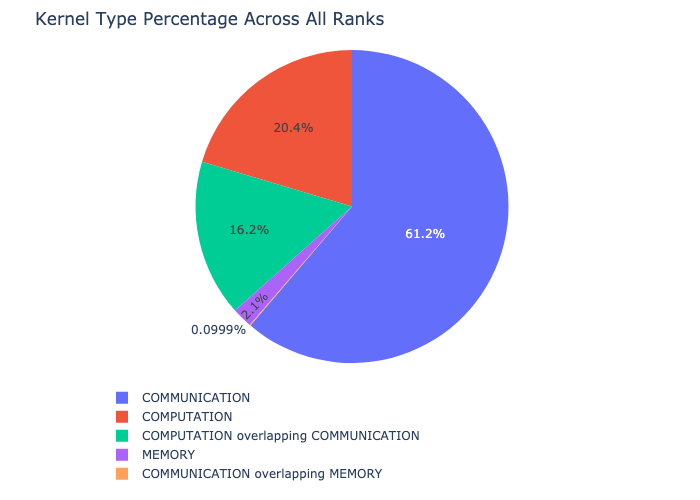

Kernel 分解功能分解了每种内核类型(例如通信 (COMM)、计算 (COMP) 和内存 (MEM))在所有 rank 上花费的时间,并显示了在每个类别中花费的时间比例。这是每个类别所花费时间的百分比饼图

Kernel 分解可以按如下方式计算

analyzer = TraceAnalysis(trace_dir = "/path/to/trace/folder")

kernel_type_metrics_df, kernel_metrics_df = analyzer.get_gpu_kernel_breakdown()

函数返回的第一个 dataframe 包含用于生成饼图的原始值。

Kernel 持续时间分布¶

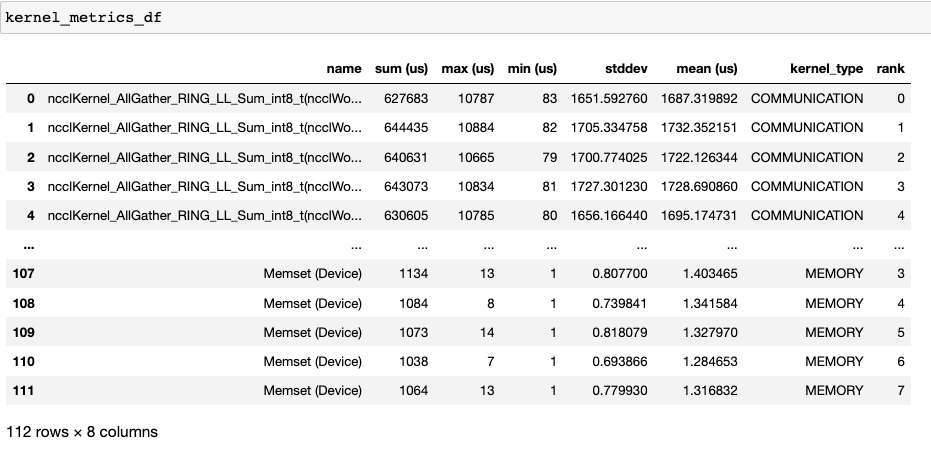

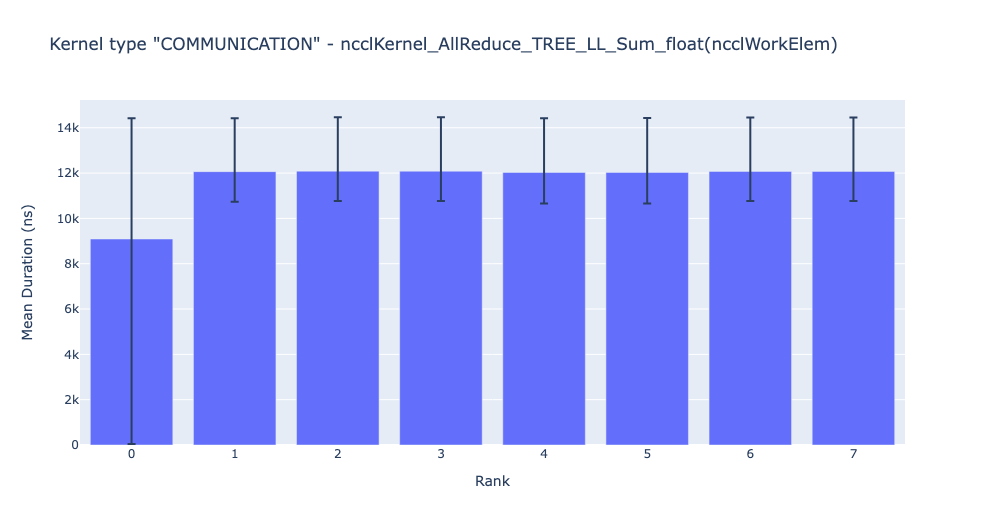

get_gpu_kernel_breakdown 返回的第二个 dataframe 包含每个内核的持续时间摘要统计信息。特别是,这包括每个 rank 上每个内核的计数、最小值、最大值、平均值、标准差、总和以及内核类型。

使用此数据,HTA 创建了许多可视化图来识别性能瓶颈。

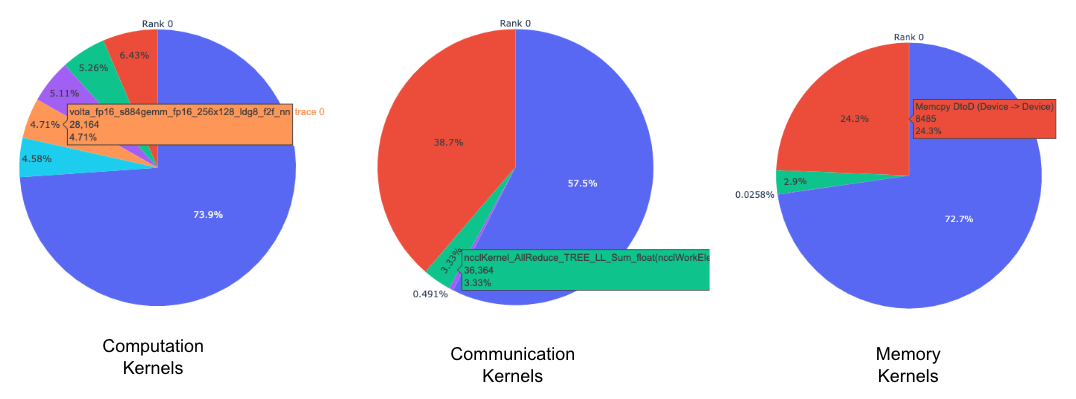

每个 rank 的每种内核类型的前 K 个内核的饼图。

所有 rank 中每个 top kernel 和每种 kernel 类型的平均持续时间条形图。

提示

所有图像均使用 plotly 生成。将鼠标悬停在图上会显示右上角的模式栏,用户可以缩放、平移、选择和下载图。

上面的饼图显示了前 5 个计算、通信和内存内核。每个 rank 都生成了类似的饼图。可以使用传递给 get_gpu_kernel_breakdown 函数的 num_kernels 参数配置饼图以显示前 k 个内核。此外,可以使用 duration_ratio 参数调整需要分析的时间百分比。如果同时指定了 num_kernels 和 duration_ratio,则 num_kernels 具有优先权。

上面的条形图显示了 NCCL AllReduce 内核在所有 rank 中的平均持续时间。黑线表示每个 rank 花费的最小和最大时间。

警告

使用 jupyter-lab 时,将“image_renderer”参数值设置为“jupyterlab”,否则图将无法在 notebook 中渲染。

有关此功能的详细演练,请参阅仓库 examples 文件夹中的 gpu_kernel_breakdown notebook。

通信计算重叠¶

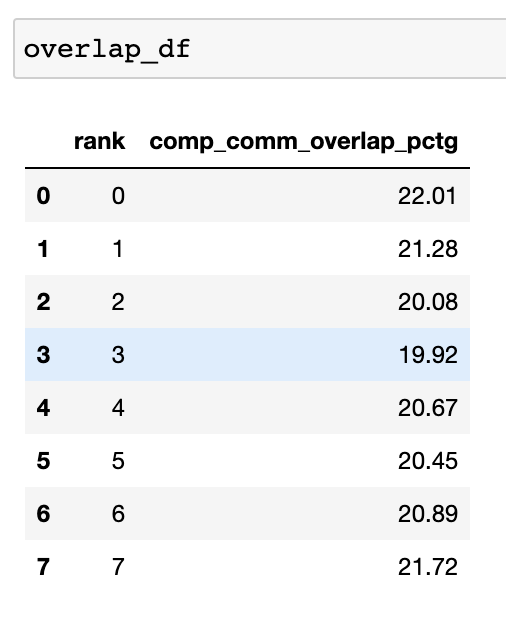

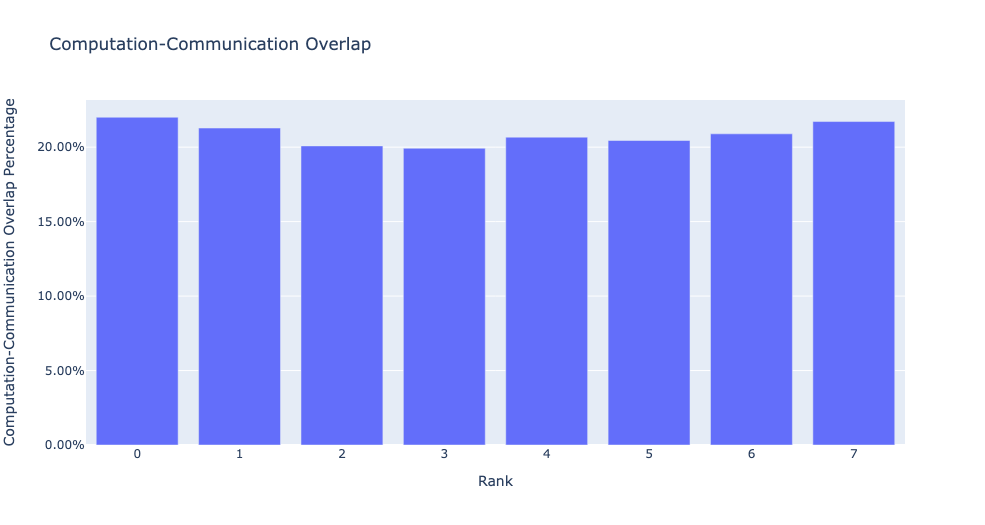

在分布式训练中,大量时间花费在 GPU 之间的通信和同步事件上。为了实现高 GPU 效率(例如 TFLOPS/GPU),关键在于通过计算内核保持 GPU 超负荷运转。换句话说,GPU 不应因未解决的数据依赖而阻塞。衡量计算被数据依赖阻塞程度的一种方法是计算通信计算重叠。如果通信事件与计算事件重叠,则观察到更高的 GPU 效率。通信和计算重叠不足会导致 GPU 空闲,从而导致效率低下。总而言之,期望有更高的通信计算重叠。为了计算每个 rank 的重叠百分比,我们测量以下比率

(通信时花费在计算上的时间)/(花费在通信上的时间)

通信计算重叠可以按如下方式计算

analyzer = TraceAnalysis(trace_dir = "/path/to/trace/folder")

overlap_df = analyzer.get_comm_comp_overlap()

该函数返回一个 dataframe,其中包含每个 rank 的重叠百分比。

当 visualize 参数设置为 True 时,get_comm_comp_overlap 函数还会生成一个按 rank 表示重叠的条形图。

增强计数器¶

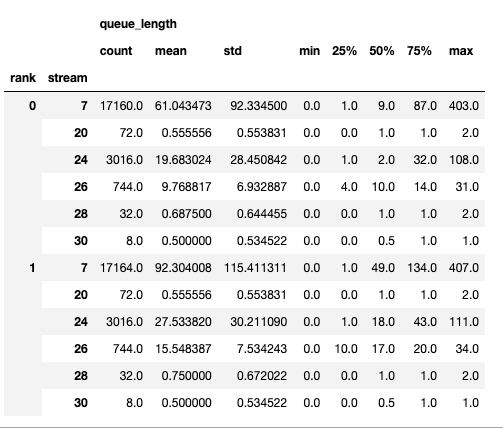

内存带宽和队列长度计数器¶

内存带宽计数器测量通过内存复制 (memcpy) 和内存设置 (memset) 事件在 H2D、D2H 和 D2D 之间复制数据时使用的内存复制带宽。HTA 还计算每个 CUDA 流上的未完成操作数。我们将此称为队列长度。当流上的队列长度达到 1024 或更大时,新事件无法在该流上调度,CPU 将停顿,直到 GPU 流上的事件处理完毕。

generate_trace_with_counters API 输出一个带有内存带宽和队列长度计数器的新跟踪文件。新跟踪文件包含指示 memcpy/memset 操作使用的内存带宽的跟踪以及每个流上队列长度的跟踪。默认情况下,这些计数器是使用 rank 0 的跟踪文件生成的,新文件的名称中包含后缀 _with_counters。用户可以选择使用 generate_trace_with_counters API 中的 ranks 参数为多个 rank 生成计数器。

analyzer = TraceAnalysis(trace_dir = "/path/to/trace/folder")

analyzer.generate_trace_with_counters()

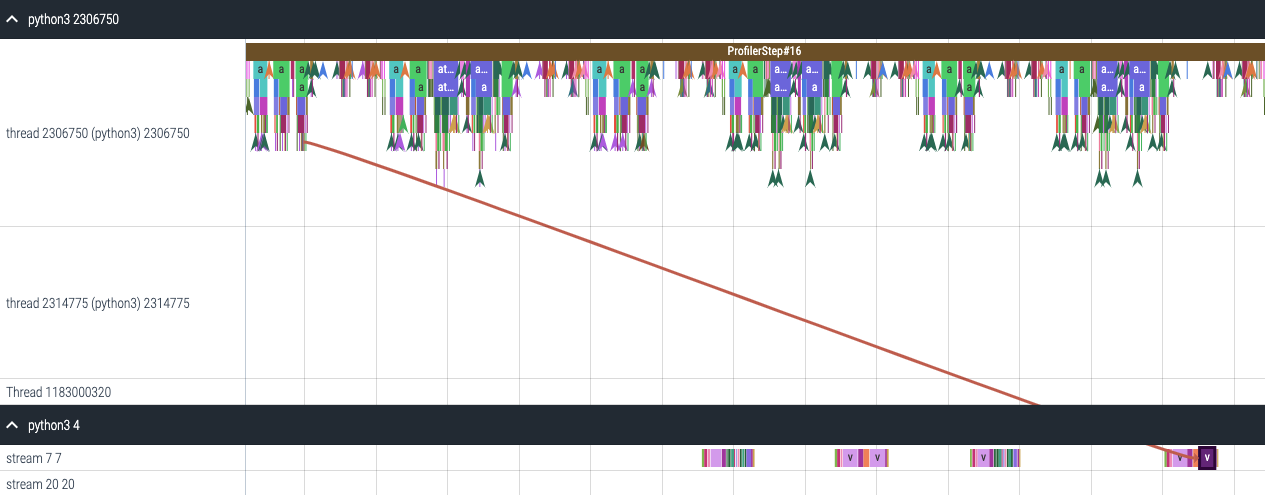

生成的带有增强计数器的跟踪文件截图。

HTA 还使用以下 API 提供了内存复制带宽和队列长度计数器的摘要以及代码分析部分的计数器时间序列

要查看摘要和时间序列,请使用

# generate summary

mem_bw_summary = analyzer.get_memory_bw_summary()

queue_len_summary = analyzer.get_queue_length_summary()

# get time series

mem_bw_series = analyzer.get_memory_bw_time_series()

queue_len_series = analyzer.get_queue_length_series()

摘要包含计数、最小值、最大值、平均值、标准差、第 25 百分位数、第 50 百分位数和第 75 百分位数。

时间序列仅包含值发生变化的点。一旦观察到值,时间序列将保持不变,直到下一次更新。内存带宽和队列长度时间序列函数返回一个字典,其键是 rank,值是该 rank 的时间序列。默认情况下,仅计算 rank 0 的时间序列。

CUDA Kernel 启动统计信息¶

对于在 GPU 上启动的每个事件,CPU 上都有相应的调度事件,例如 CudaLaunchKernel、CudaMemcpyAsync、CudaMemsetAsync。这些事件通过跟踪中的公共相关 ID 链接在一起 - 参见上图。此功能计算 CPU 运行时事件的持续时间、其对应的 GPU 内核以及启动延迟,例如 GPU 内核启动与 CPU 操作符结束之间的时间差。内核启动信息可以按如下方式生成

analyzer = TraceAnalysis(trace_dir="/path/to/trace/dir")

kernel_info_df = analyzer.get_cuda_kernel_launch_stats()

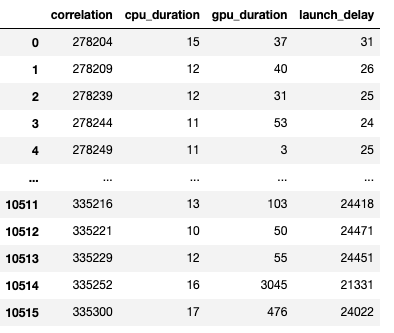

生成的 dataframe 截图如下所示。

CPU 操作、GPU 内核和启动延迟的持续时间使我们能够发现以下情况

短 GPU 内核 - 持续时间小于相应 CPU 运行时事件的 GPU 内核。

运行时事件异常值 - 持续时间过长的 CPU 运行时事件。

启动延迟异常值 - 需要很长时间才能被调度的 GPU 内核。

HTA 为上述三个类别中的每一个生成分布图。

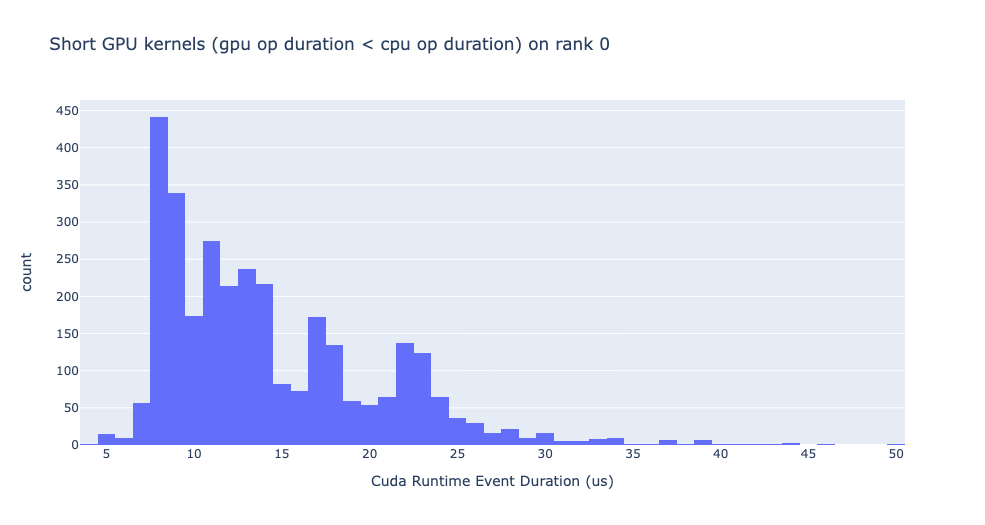

短 GPU 内核

通常,CPU 端的启动时间范围在 5-20 微秒。在某些情况下,GPU 执行时间低于启动时间本身。下图有助于我们了解代码中此类实例发生的频率。

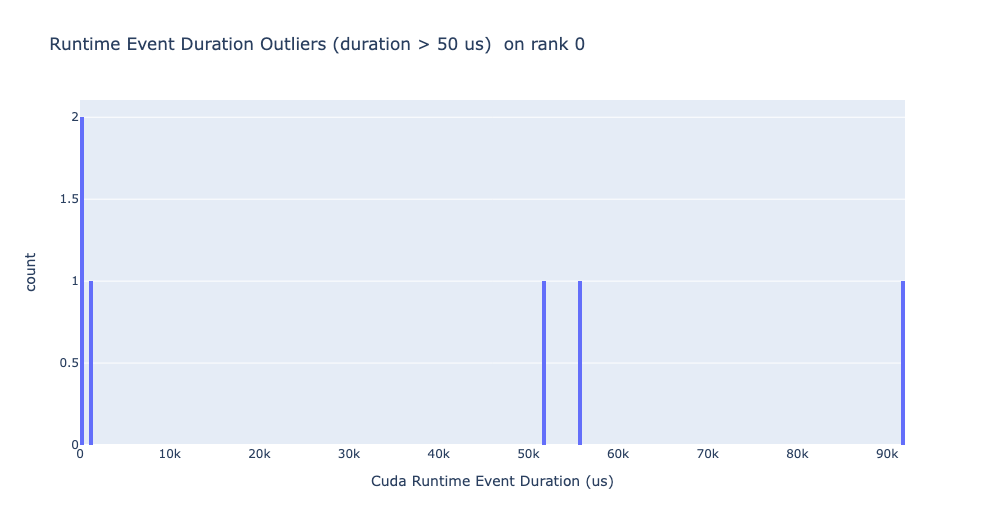

运行时事件异常值

运行时异常值取决于用于对异常值进行分类的截止值,因此 get_cuda_kernel_launch_stats API 提供了 runtime_cutoff 参数来配置该值。

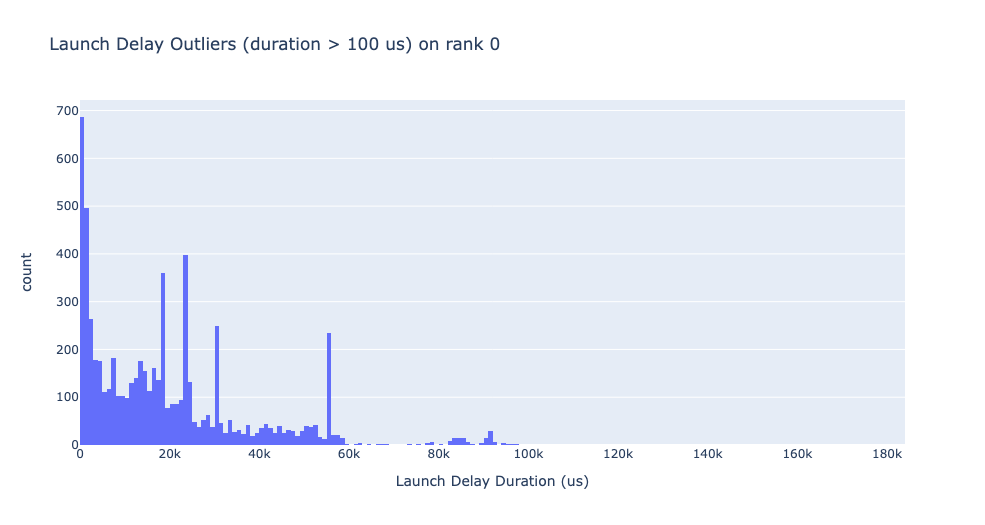

启动延迟异常值

启动延迟异常值取决于用于对异常值进行分类的截止值,因此 get_cuda_kernel_launch_stats API 提供了 launch_delay_cutoff 参数来配置该值。

结论¶

在本教程中,您学习了如何安装和使用 HTA,这是一个性能工具,可帮助您分析分布式训练工作流中的瓶颈。要了解如何使用 HTA 工具执行跟踪对比分析,请参阅使用整体跟踪分析进行跟踪对比。