SELU¶

- class torch.nn.SELU(inplace=False)[source][source]¶

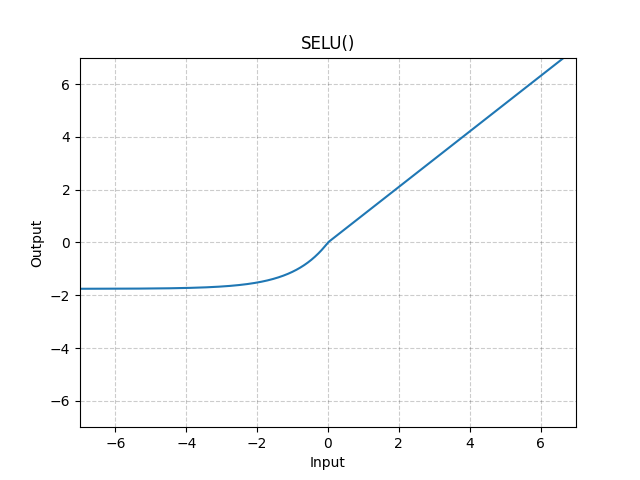

逐元素地应用 SELU 函数。

其中 和 。

警告

在使用

kaiming_normal或kaiming_normal_进行初始化时,应使用nonlinearity='linear'而不是nonlinearity='selu'来实现 自归一化神经网络。有关更多信息,请参阅torch.nn.init.calculate_gain()。更多细节可以在论文 Self-Normalizing Neural Networks 中找到。

- 参数

inplace (布尔类型, 可选) – 可以选择原地执行操作。默认值:

False

- 形状

输入: , 其中 表示任意维度数量。

输出: , 形状与输入相同。

示例

>>> m = nn.SELU() >>> input = torch.randn(2) >>> output = m(input)