Wav2Vec2ASRBundle¶

- class torchaudio.pipelines.Wav2Vec2ASRBundle[source]¶

一个数据类,捆绑了使用预训练的

Wav2Vec2Model所需的相关信息。此类提供了用于实例化预训练模型的接口,以及检索预训练权重和模型所需额外数据的必要信息。

Torchaudio 库实例化此类的对象,每个对象代表一个不同的预训练模型。客户端代码应通过这些实例访问预训练模型。

请参阅下方了解用法和可用值。

- 示例 - ASR

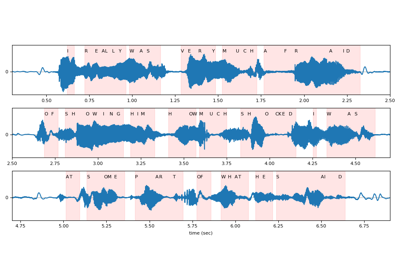

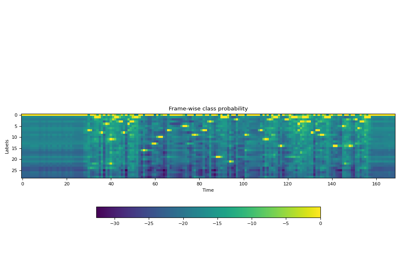

>>> import torchaudio >>> >>> bundle = torchaudio.pipelines.HUBERT_ASR_LARGE >>> >>> # Build the model and load pretrained weight. >>> model = bundle.get_model() Downloading: 100%|███████████████████████████████| 1.18G/1.18G [00:17<00:00, 73.8MB/s] >>> >>> # Check the corresponding labels of the output. >>> labels = bundle.get_labels() >>> print(labels) ('-', '|', 'E', 'T', 'A', 'O', 'N', 'I', 'H', 'S', 'R', 'D', 'L', 'U', 'M', 'W', 'C', 'F', 'G', 'Y', 'P', 'B', 'V', 'K', "'", 'X', 'J', 'Q', 'Z') >>> >>> # Resample audio to the expected sampling rate >>> waveform = torchaudio.functional.resample(waveform, sample_rate, bundle.sample_rate) >>> >>> # Infer the label probability distribution >>> emissions, _ = model(waveform) >>> >>> # Pass emission to decoder >>> # `ctc_decode` is for illustration purpose only >>> transcripts = ctc_decode(emissions, labels)

- 使用

Wav2Vec2ASRBundle的教程

属性¶

sample_rate¶

方法¶

get_labels¶

- Wav2Vec2ASRBundle.get_labels(*, blank: str = '-') Tuple[str, ...][source]¶

输出类别标签。

第一个是空白标记,它是可定制的。

- 示例

>>> from torchaudio.pipelines import HUBERT_ASR_LARGE as bundle >>> bundle.get_labels() ('-', '|', 'E', 'T', 'A', 'O', 'N', 'I', 'H', 'S', 'R', 'D', 'L', 'U', 'M', 'W', 'C', 'F', 'G', 'Y', 'P', 'B', 'V', 'K', "'", 'X', 'J', 'Q', 'Z')

get_model¶

- Wav2Vec2ASRBundle.get_model(*, dl_kwargs=None) Module¶

构造模型并加载预训练权重。

权重文件将从互联网下载,并使用

torch.hub.load_state_dict_from_url()进行缓存- 参数:

dl_kwargs (关键字参数字典) – 传递给

torch.hub.load_state_dict_from_url()。- 返回值:

Wav2Vec2Model的变体。对于下面列出的模型,对输入执行额外的层归一化。

对于所有其他模型,返回一个

Wav2Vec2Model实例。WAV2VEC2_LARGE_LV60K

WAV2VEC2_ASR_LARGE_LV60K_10M

WAV2VEC2_ASR_LARGE_LV60K_100H

WAV2VEC2_ASR_LARGE_LV60K_960H

WAV2VEC2_XLSR53

WAV2VEC2_XLSR_300M

WAV2VEC2_XLSR_1B

WAV2VEC2_XLSR_2B

HUBERT_LARGE

HUBERT_XLARGE

HUBERT_ASR_LARGE

HUBERT_ASR_XLARGE

WAVLM_LARGE