ExecuTorch Llama iOS 演示应用程序¶

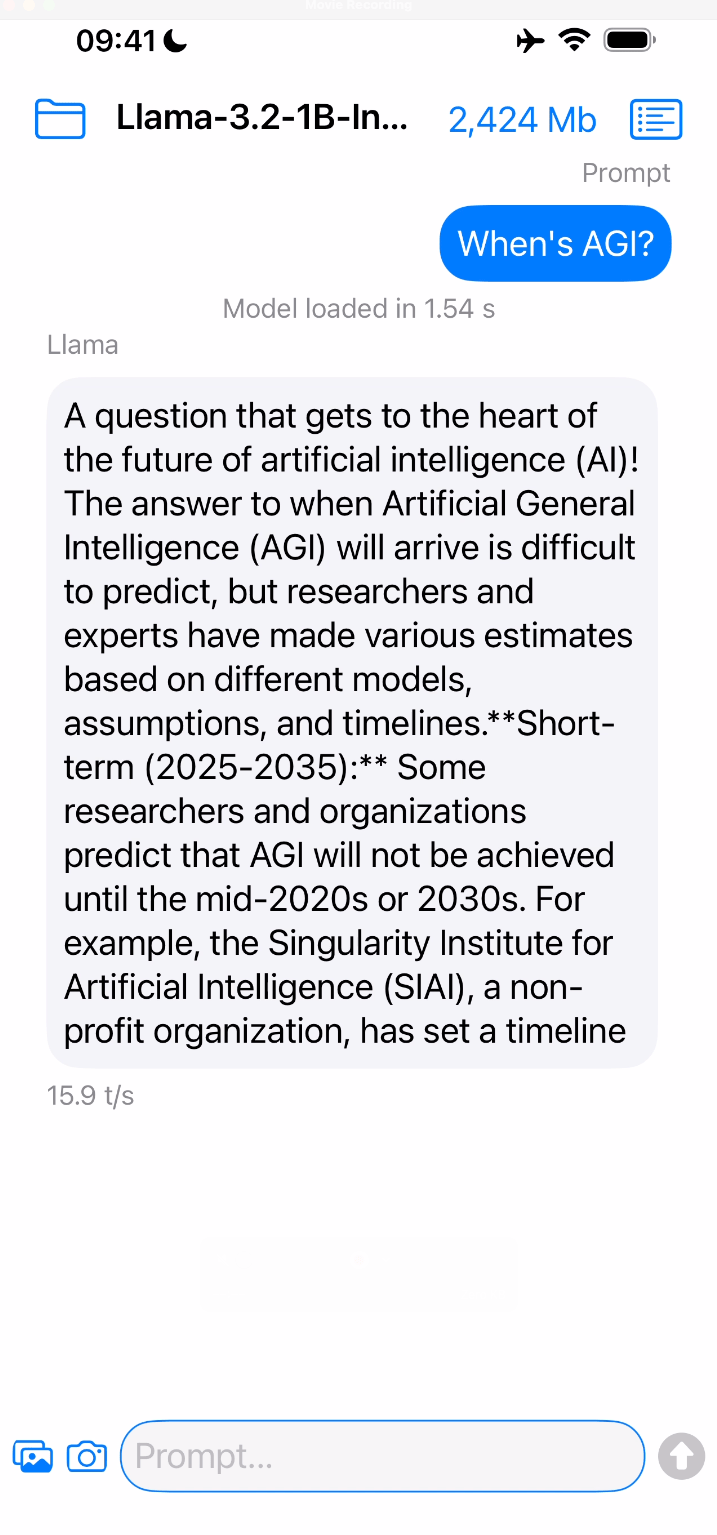

亲身体验在您的 iOS 设备上原生运行通过 ExecuTorch 导出的 LLaMA 和 LLaVA 模型!

点击下方图片查看实际效果!

要求¶

Xcode 15.0 或更高版本

Cmake 3.19 或更高版本

下载并打开 macOS 的

.dmg安装程序,然后将 Cmake 应用程序移动到/Applications文件夹。安装 Cmake 命令行工具:

sudo /Applications/CMake.app/Contents/bin/cmake-gui --install

一个具有

increased-memory-limit权限的开发 provisioning profile。

模型¶

从 HuggingFace 下载已导出的 LLaMA/LLaVA 模型及分词器,或者自行导出由 XNNPACK 或 MPS 后端加速的模型。

构建并运行¶

确保 git 子模块是最新的

git submodule update --init --recursive

打开 Xcode 项目

open examples/demo-apps/apple_ios/LLaMA/LLaMA.xcodeproj点击运行按钮,在模拟器中启动应用程序。

要在设备上运行,请确保已将其设置为开发模式,并且具有

increased-memory-limit权限的 provisioning profile。更新应用程序的 bundle identifier 以匹配具有所需功能的 provisioning profile。成功启动应用程序后,将导出的 ExecuTorch 模型 (

.pte) 和分词器 (.model) 文件复制到 iLLaMA 文件夹中。对于模拟器:将两个文件拖放到模拟器窗口中,并将其保存在

On My iPhone > iLLaMA文件夹中。对于设备:打开一个单独的 Finder 窗口,导航到“文件”标签页,将两个文件拖放到 iLLaMA 文件夹中,然后等待复制完成。

按照应用程序的用户界面指南从本地文件系统选择模型和分词器文件,并输入提示语。

更多详细信息,请查阅在 iOS 上使用 ExecuTorch 页面。