登录 Weights & Biases¶

本深度解析将指导您如何在 torchtune 中设置登录到 Weights & Biases (W&B)。

如何开始使用 W&B

如何使用

WandBLogger如何将配置、指标和模型检查点记录到 W&B

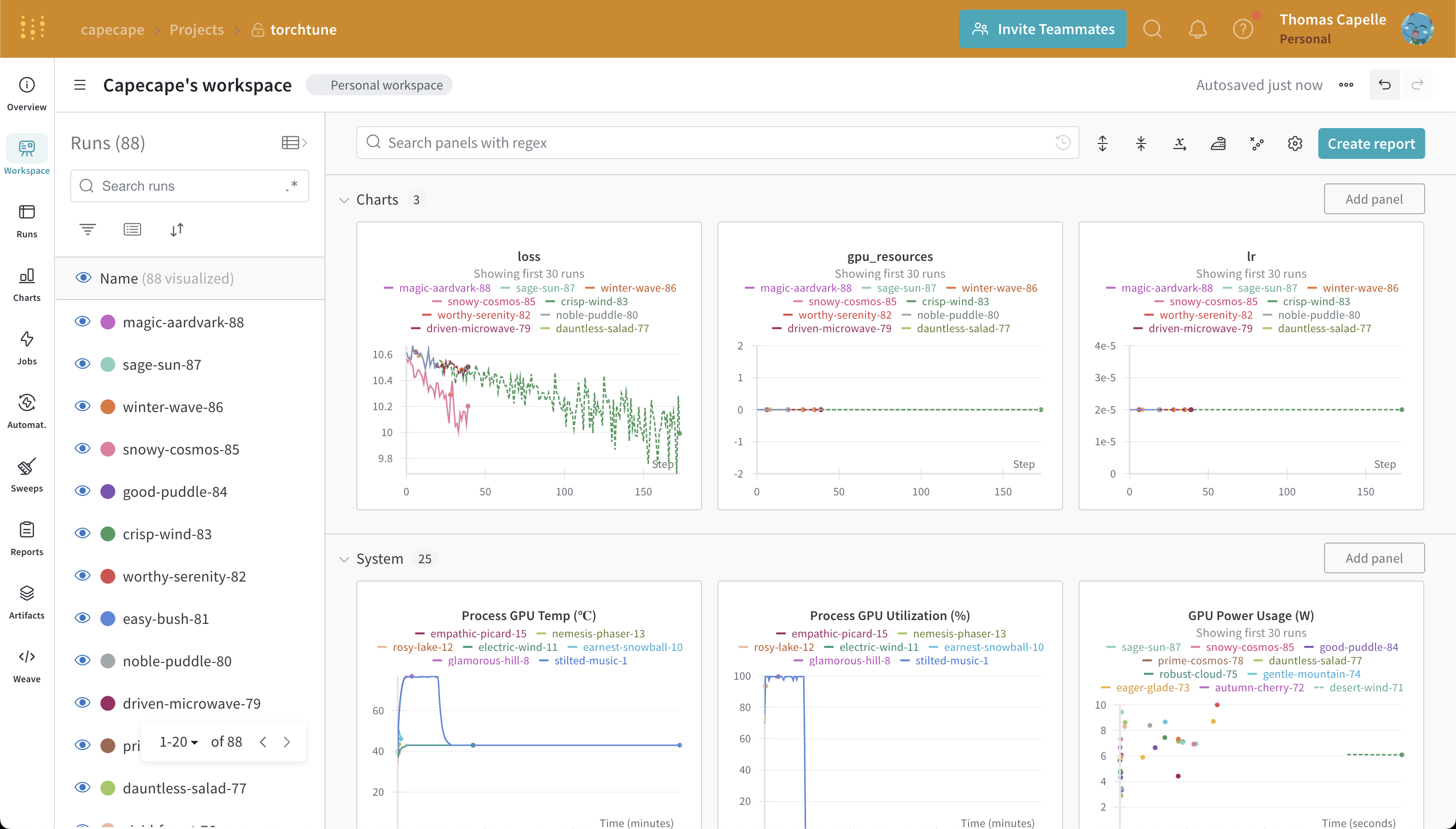

torchtune 支持将您的训练运行记录到 Weights & Biases。torchtune 微调运行的一个 W&B 工作区示例如下所示。

注意

您需要安装 wandb 包才能使用此功能。您可以通过 pip 安装它

pip install wandb

然后您需要使用 W&B CLI 和您的 API 密钥登录

wandb login

指标记录器¶

您唯一需要做的更改是将指标记录器添加到您的配置中。Weights & Biases 将为您记录指标和模型检查点。

# enable logging to the built-in WandBLogger

metric_logger:

_component_: torchtune.training.metric_logging.WandBLogger

# the W&B project to log to

project: torchtune

我们自动抓取您正在运行的实用示例的配置,并将其记录到 W&B。您可以在 W&B 概览选项卡和 Files 选项卡中找到实际文件。

提示:如果您的作业崩溃或在未清理资源的情况下退出,您可能会看到一些 wandb 僵尸进程在后台运行。要终止这些僵尸进程,可以使用类似 ps -aux | grep wandb | awk '{ print $2 }' | xargs kill 的命令。

注意

点击此示例 项目查看 W&B 工作区。用于训练模型的配置可以在这里找到。

将模型检查点记录到 W&B¶

您也可以通过修改所需脚本的 save_checkpoint 方法,将模型检查点记录到 W&B。

建议的方法如下

def save_checkpoint(self, epoch: int) -> None:

...

## Let's save the checkpoint to W&B

## depending on the Checkpointer Class the file will be named differently

## Here is an example for the full_finetune case

checkpoint_file = Path.joinpath(

self._checkpointer._output_dir, f"torchtune_model_{epoch}"

).with_suffix(".pt")

wandb_at = wandb.Artifact(

name=f"torchtune_model_{epoch}",

type="model",

# description of the model checkpoint

description="Model checkpoint",

# you can add whatever metadata you want as a dict

metadata={

training.SEED_KEY: self.seed,

training.EPOCHS_KEY: self.epochs_run,

training.TOTAL_EPOCHS_KEY: self.total_epochs,

training.MAX_STEPS_KEY: self.max_steps_per_epoch,

}

)

wandb_at.add_file(checkpoint_file)

wandb.log_artifact(wandb_at)