2025年6月7日,PyTorch Day China 在北京成功举办,由 PyTorch Foundation 和北京智源人工智能研究院 (BAAI) 联合主办。为期一天的会议共进行了16场演讲,平均每场会议有160名参会者。浏览完整的 YouTube 播放列表,查找您感兴趣的会议。

PyTorch Foundation 执行董事 Matt White 深入阐述了 PyTorch Foundation 致力于加速开源 AI 的承诺。基金会自两年前成立以来,已发展到30名成员,并演变为一个伞形基金会,能够托管 PyTorch 核心之外的开源项目。vLLM 和 DeepSpeed 成为基金会旗下的首批项目,BAAI 的开源项目 FlagGems 也加入了 PyTorch 生态系统。为支持本地社区发展而启动的 PyTorch 大使计划在一个月内收到了200多份申请。Matt 还介绍了 PyTorch 新网站,以及 PyTorch 大会和开源 AI 周的日程安排。他提到了基金会即将推出的举措,包括演讲者名录、大学合作和培训认证,并感谢了与会者,表达了对当天演讲的期待。

2. 在多样化 AI 芯片上运行大模型:PyTorch + 开源堆栈 (FlagOS) 实现无架构部署

北京智源人工智能研究院副院长林咏华讨论了当前在多样化 AI 芯片上运行大模型的现状。她解释了构建统一开源系统软件堆栈的原因:大模型面临成本高昂、资源需求巨大以及训练/推理昂贵等挑战,而碎片化的全球 AI 加速器生态系统又带来了额外问题。随后,她介绍了由智源研究院与多个合作伙伴共同开发的 FlagOS,包括核心组件和必要工具,支持各种底层芯片和系统部署架构,以及多种大模型。它已获得多种架构的支持,并在算子效率和兼容性方面表现出色。最后,她呼吁更多团队参与构建这个开源生态系统。

3. 深入 Hugging Face Hub;在第一大 AI 中心,70万+ PyTorch 模型的家园分享您的模型权重

来自 HuggingFace 的王铁铮介绍了 HuggingFace Hub,这是一个常被称为“AI 的 GitHub”的开源 AI 社区。它托管了大量的开源模型和数据集,并提供多样化的功能:用于轻松测试模型的空间、内核、API 提供商网关、社交沟通功能以及与开源相关的指标。其模型库提供按受欢迎程度和任务进行便捷过滤的功能,并设有热门模型页面,展示各种热门模型。每个模型都有一个专门的页面,显示模型卡、代码和结构化数据。对于数据集,它支持 Git 仓库,提供可视化和 SQL 查询功能,并提供强大的编程接口。

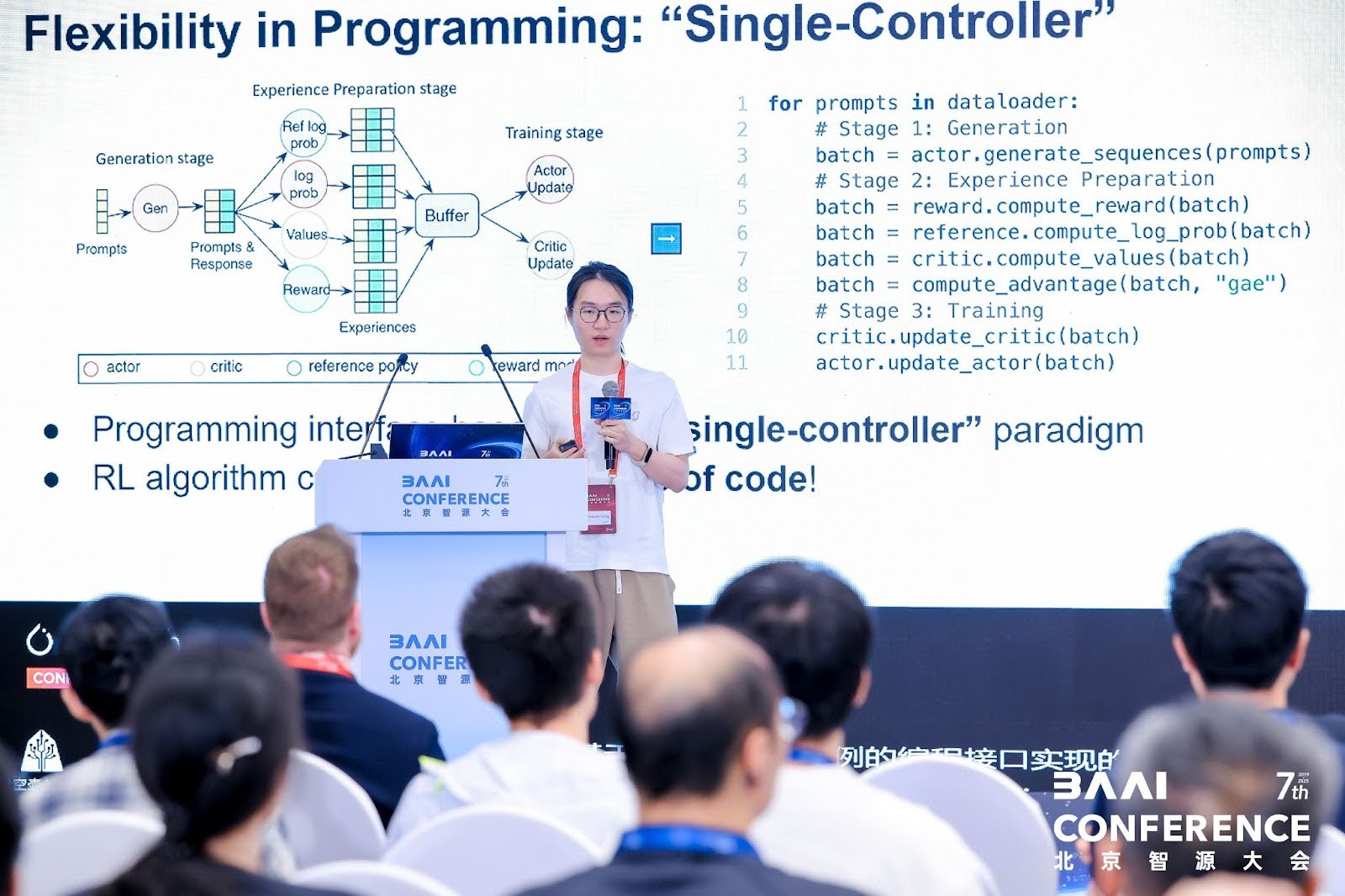

4. Verl:一个用于代理任务的开源大规模 LLM 强化学习框架

来自字节跳动的仝宇轩介绍了verl,这是一个开源的大规模 LLM 强化学习框架。他首先强调了大规模强化学习的重要性,它显著增强了语言模型的性能,并在实际任务中具有广泛应用。然而,它面临着复杂的数据流(涉及多个模型、阶段和工作负载)、分布式工作负载以及平衡数据依赖和资源约束的挑战。Verl 的优势在于平衡了灵活性和效率:它通过单一控制器范式实现了编程灵活性,允许用最少的代码描述核心逻辑并支持多种算法,并且它具有混合引擎以优化资源利用。该框架拥有一个活跃的开源社区,有几个流行的项目都建立在其之上。最后,他分享了社区的未来路线图并欢迎新成员。

5. PyTorch 在中国:社区增长、本地化与互动

来自华为的宗泽胜讨论了 PyTorch 在中国的发展。作为全球流行的框架,PyTorch 拥有大量来自中国的贡献者,在全球名列前茅。为了解决初学者本地化资源匮乏的问题,他们翻译了 PyTorch 官方网站,建立了社区主页,并翻译了从初级到高级的教程。他们还通过聊天频道(去年底建立)积极与用户互动,发布了60多篇技术博客,并获得了2500名订阅者。未来的计划包括进一步自动化翻译,提供更多高质量的资源和活动,并邀请用户参与。

6. AI 开源发展及其对 AI 生态系统的影响

CSDN 高级副总裁兼 Boulon 技术专家李建忠分享了对 AI 开源发展及其对 AI 生态系统影响的见解。他比较了全球和中国的 AI 技术生态系统,指出中国的 AI 开源在全球的重要性日益增加,并将 AI 的发展与地球上生物智能的演变进行了类比。随后,他讨论了推理模型的发展,这些模型使大模型能够“慢思考”,并减少对训练语料库中弱推理信号的依赖,其中强化学习中的机器合成数据发挥着关键作用。他分析了开源对生态系统的影响,包括大幅降低模型训练和推理成本,并推动 AI 应用向能够规划、协作和行动的代理发展。

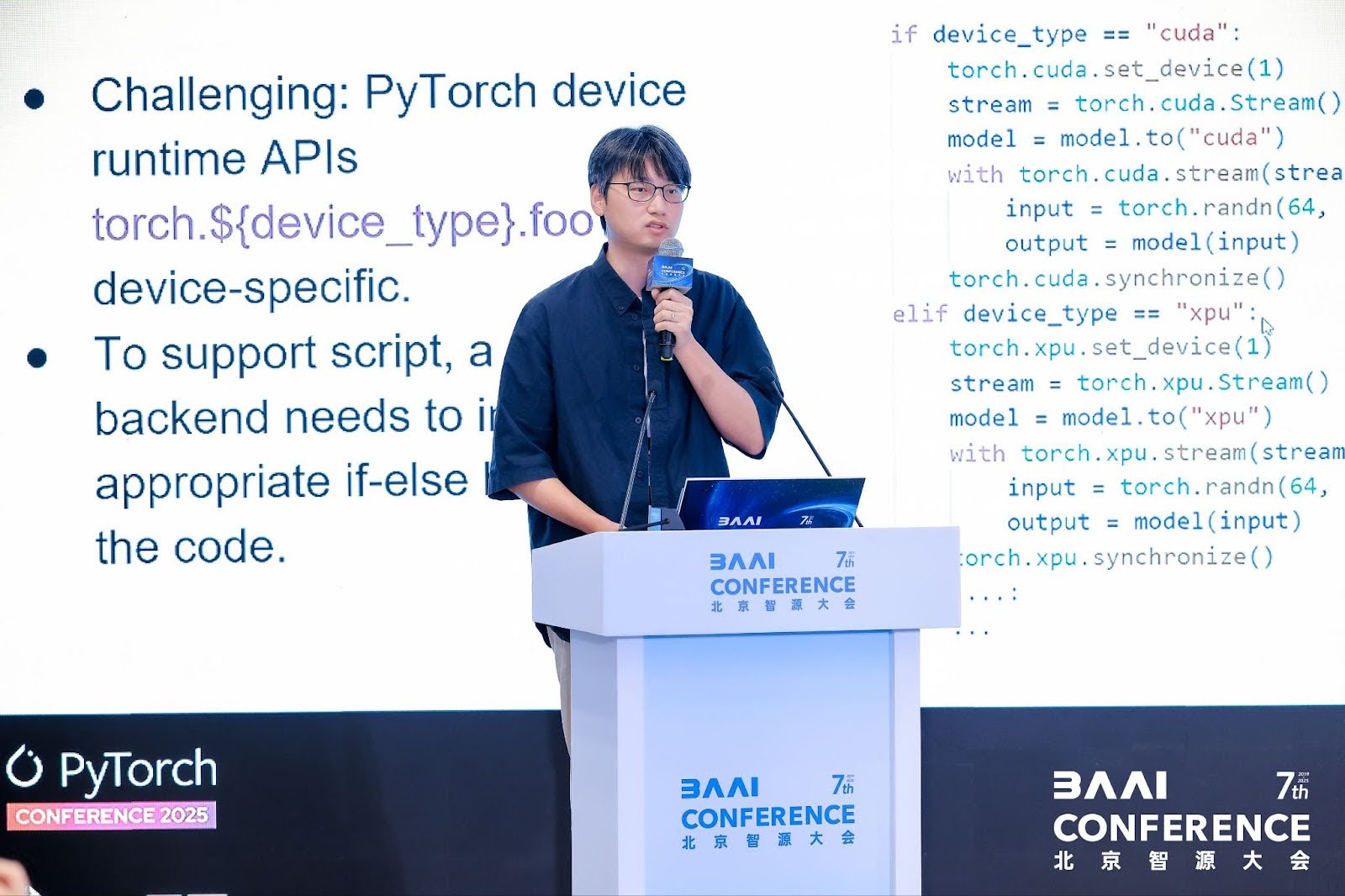

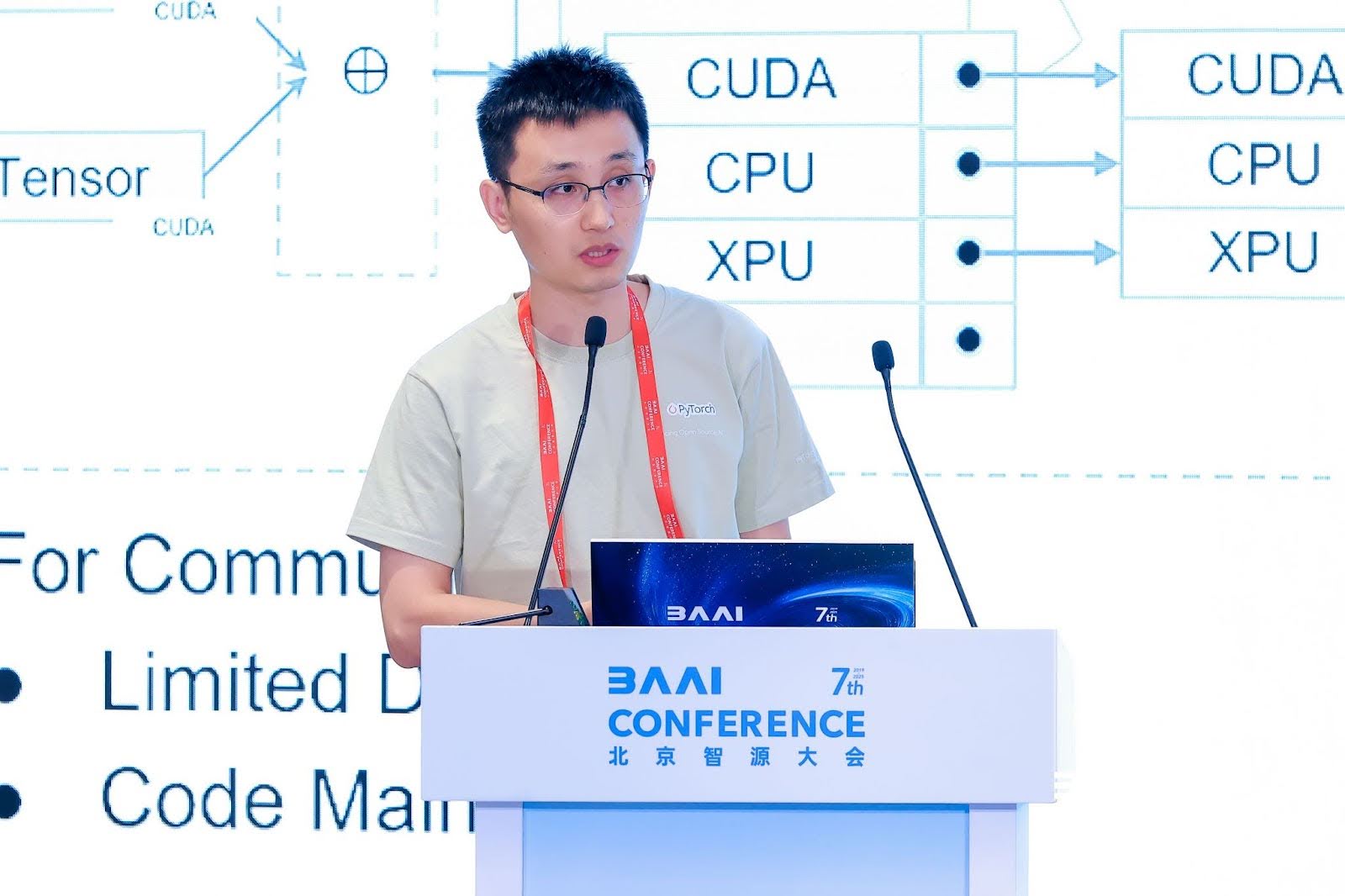

7. torch.accelerator:用于基于流的加速器的统一、设备无关的运行时 API

来自英特尔的余广业介绍了 PyTorch 2.6 中推出的torch.accelerator API,这是一个用于基于流的加速器的统一、设备无关的运行时 API。尽管 PyTorch 作为一个广泛使用的机器学习框架支持各种加速硬件,但现有的运行时与特定的设备模块耦合(例如,`torch.cuda.current_device` 仅适用于 CUDA 设备),这限制了代码的可移植性,并给硬件供应商集成新后端带来了挑战。PyTorch 2.5 引入了加速器的概念,2.6 提出了一个统一的设备无关的运行时 API,其功能与现有设备特定的 API 紧密映射,以最大限度地减少代码迁移更改。未来的计划包括添加内存相关的 API 和通用单元测试。最后,他感谢社区和贡献者为这些改进所做的努力。

8. vLLM:人人都能轻松、快速、廉价地进行 LLM 服务

来自清华大学的游凯超介绍了vLLM,旨在为所有人提供易于访问、快速且经济实惠的语言模型推理服务。它于2023年6月开源,凭借近4.83万的 GitHub 星标而受到广泛关注。它易于使用,支持离线批处理推理和与 OpenAI 兼容的 API 服务器,并适用于各种模型类型。作为主要语言模型公司的官方合作伙伴,它可以在模型发布后立即部署。vLLM 支持多种硬件,探索基于插件的集成,并应用于日常生活和企业应用。它通过软件包、Docker 镜像、预编译的 wheel 和强大的持续集成系统优先考虑用户体验。最后,他感谢 vLLM 社区的1100多名贡献者。

9. 一个由 torch_musa 驱动的基于 torch.fx 的压缩工具包

来自摩尔线程的莫凡介绍了torch_musa,这是一个 PyTorch 插件,使 PyTorch 能够在其平台上原生运行,并具有高度优化的功能和算子。随后,他详细介绍了压缩工具包,解释了选择 FX(可调试、易于修改图、易于集成)的原因。其工作流程涉及输入模型和配置文件,在跟踪阶段捕获完整的模型图,并通过后端进行优化/缩减。他还介绍了定制优化和对多种数据类型的支持。未来的工作包括使大型语言和视觉模型可跟踪、加速推理以及构建容错系统。

10. 字节跳动视频生成基础模型的高效训练

来自字节跳动的张衡分享了字节跳动在视频生成基础模型大规模、高性能训练方面的经验,包括在广告、电影和动画中的应用。他介绍了视频生成模型的结构(VE 编码、MMDIT 扩散、VE 解码)和训练过程(分阶段训练,VE 编码离线以优化存储和预处理)。他还讨论了视频生成模型中负载不平衡的挑战和解决方案。

11. torch.compile 在不同场景下的实践与优化

来自阿里云的颜奕晨分享了团队在 `torch.compile` 实践与优化方面的经验。`torch.compile` 通过图捕获、回退处理和优化内核生成等组件,仅用一行代码即可加速模型,但在生产环境中面临挑战。为解决这些问题,团队解决了 Dynamo 和 DeepSpeed ZeRO/梯度检查点之间的兼容性,并向相关库提交了集成解决方案;通过模式匹配识别并重写注意力计算模式,以实现更好的融合和性能;优化了输入对齐以减少不必要的重新编译。他还提到了未解决的问题和未来方向:动态形状的编译策略、启动延迟优化、减少开销以及改进内核缓存机制。

12. 生产环境中的 PyTorch:在昇腾 NPU 上加速 LLM 训练和推理

来自华为的李嘉伟和李晶介绍了 PyTorch 生态系统中昇腾 NPU (torch_npu) 的进展。他们重点关注 PyTorch 上游多样性支持,解释了第三方设备集成机制:使用基于 CPU 的模拟后端 OpenRag 作为测试后端来监控接口功能,并建立机制供下游硬件供应商在社区 PR 合并之前识别风险。

李晶分享了昇腾 NPU 的性能和生态系统支持。他介绍了torch_npu 架构以实现高性能和可靠性。目前已支持20多个流行库,包括 vLLM、torchtune、torchtitan 等。他还解释了 torch_npu 与 NPUGraph 和 torch.compile 协同工作的机制,以提供高性能计算。最后,他邀请大家加入社区并参加定期会议。

13. Hetu-Galvatron:一个用于高效大规模基础模型训练的自动分布式系统

来自北京大学的刘心怡和王宇杰详细介绍了Hetu-Galvatron,这是一个基于 PyTorch 的创新系统,其主要特点是:自动优化、多功能性和用户友好性。对于模型转换,它基于原生 PyTorch 构建,通过替换支持张量和同步比较的层,将单 GPU 训练模型转换为支持多并行度的模型。对于自动优化,它拥有一个基于成本模型和搜索算法的引擎。它支持多样化的模型架构和硬件后端,通过 PyTorch 确保与 GPU 和 NPU 的集成。它在不同的集群和模型上表现出卓越的效率,并验证了性能和准确性。未来的计划包括集成 torch FSDP2,支持更多并行策略,更多模型和注意力类型,以及优化训练后工作流程。

14. 英特尔的 PyTorch 之旅:提升 AI 性能并优化开源软件

来自英特尔 PyTorch 团队的马明飞介绍了英特尔在 PyTorch 方面的工作。对于英特尔 GPU 上的 PyTorch 优化,英特尔在 Linux 和 Windows 上提供支持,涵盖运行时、算子支持、`torch.compile` 和分布式训练。对于 `torch.compile` 中的 CPU 后端优化,团队参与了架构设计,扩展了数据类型支持,实现了 gemm 模板的自动调优,支持 Windows,并持续改进性能加速。对于 DeepSeek 671B 完整版性能优化,团队完成了 CPU 后端开发,取得了显著的加速(预填充性能提升14倍,解码性能提升2.9倍),支持多种数据类型,以低成本满足了实时需求。

15. FlagTree:适用于多样化 AI 芯片的统一 AI 编译器

来自北京智源人工智能研究院的孟春雷介绍了FlagTree,一个支持多样化 AI 芯片的统一 AI 编译器,也是 FlagOS 开源堆栈的关键组件。FlagOS 由智源研究院与多个合作伙伴共同开发,包括FlagGems(大型模型通用算子库)、FlagCX(多芯片通信)以及并行训练/推理框架,支持大型模型训练和推理。他还介绍了 FlagTree 用于多后端集成的架构,以及正在开发的功能:基于注解的编程范式、重构的 Triton 编译器运行时等,通过相关优化显著提升了性能。

16. KTransformers:释放 MoE 模型 CPU/GPU 混合推理的全部潜力

来自清华大学的张明行博士介绍了KTransformers,即 Quick Transformers,这是一个构建在 HuggingFace 的 Transformers 之上的库,旨在通过优化的算子集成和数据布局策略,释放 MoE 模型 CPU/GPU 混合推理的潜力。最初设计为一个灵活的框架,用于集成各种算子优化,它解决了由于模型更大和上下文更长而导致的推理成本上升问题。对于低吞吐量和并发场景,它通过将计算密集型部分卸载到 GPU,将稀疏部分卸载到 CPU(针对 DeepSeek 等模型量身定制),并具有灵活的配置,实现了低门槛模型操作。未来的重点包括注意力层稀疏化、添加局部微调以及维护用于分布式推理的Mooncake项目,欢迎社区交流。

17. SGLang:一个用于大规模 LLM 服务的高效开源框架

来自上海交通大学的研究生殷梁生介绍了SGLang,一个用于大规模 LLM 服务的高效开源框架。作为一个性能领先的开源引擎,具有优雅、轻量级和可定制的设计,它被学术界以及微软和 AMD 等公司采用,提供高性能的强化学习解决方案。其核心是 PD 解耦设计,解决了非解耦模式中的问题:延迟、计算-通信不平衡和调度不兼容。它通过负载均衡器路由请求,实现预取和解码实例之间的 KV 缓存传输。未来的计划包括延迟优化、更长序列支持和集成数据并行注意力。拥有400多名贡献者,它被多家企业使用。